投研早报丨Layer3 概念引热议,如何理解其扩展意义?/ EVM 并行化探索:Post-Parallel EVM 时代如何发展?/ 以太坊核心开发者会议:考虑将 EIP 7547 纳入 Electra、peerDAS 开发…

ChainFeeds Newsletter 每日精选 Web3 深度投研「简报」+ AI 驱动的热点新闻榜单,帮你做出聪明决策

📢 ChainBuzz 热点新闻 |2024.4.8

🔥 Ripple CEO 预计今年加密货币市场的总市值将翻一番,突破 5 万亿美元

🔥 Atomicals Protocol:ARC-20 拆分方案已进入 Beta 版本测试阶段

🔥 本周代币解锁数据:APT、GLMR 和 EUL 等将迎来一次性大额解锁

🔥 Aave 社区投票通过「在 Aave V3 以太坊上支持 ezETH 借贷」温度检查提案

🔥 dYdX 向 Stride 质押 2000 万枚代币提案已获通过

🔥 AltLayer 已于测试网启动 MACH AVS

👨💻 ChainFeeds 投研简报 |2024.4.4 - 4.7

1️⃣ 以太坊|以太坊核心开发者最新会议摘要:考虑将 EIP 7547 纳入 Electra、peerDAS 开发…

2️⃣ 观点|Arthur Hayes 播客:加密货币是一艘救生船 带我们逃离动荡周期

3️⃣ 研究|对话 FLock.io CEO:为什么谷歌不能做真正的联邦学习,而区块链可以?

4️⃣ 观点|AC:Ethena 或是下一个 UST?

5️⃣ 研究|以 Monad、MegaETH、Sei 和 Canto 为例,探索 EVM 的性能优化设计

6️⃣ 研究|EVM 并行化探索:Post-Parallel EVM 时代会如何发展?

7️⃣ 观点|Layer3 概念引激烈讨论,究竟该如何理解其扩展意义?

8️⃣ 项目介绍|ABCDE:我们为什么要投资 UTXO Stack

9️⃣ 研究|以太坊验证者数量超 100 万,「彩虹质押」如何缓解质押中心化问题?

1️⃣0️⃣ 项目介绍|从存储过去到计算未来: AO 超并行计算机

每日精选的加密信息由 ChainFeeds 团队与 AI 共同编写,我们已将内部的信息流工具优化并开放给所有读者及 Web3 行业者使用,测试链接 👇

🌞 Web3 行研早报来自:Web3 行业必读深度资讯「简报」平台|chainfeeds.xyz

🤖️ Web3 热点榜单来自:AI 驱动的 Web3 热点新闻自动聚合工具|chainbuzz.xyz

1️⃣ 以太坊核心开发者最新会议摘要:考虑将 EIP 7547 纳入 Electra、peerDAS 开发…

导读:ACDC 第 131 次电话会议上,开发人员讨论和协调了以太坊共识层(CL)的变化。开发人员简要讨论了与 Deneb 升级相关的 2 个主题,并享了 4 个已被批准纳入 Electra 升级的 EIP 的实施情况。Galaxy Digital 研究副总裁 Christine Kim 对本次会议要点做了详细记录。

Christopher Rhine(Galaxy Digital 总经理): 4 个已被批准纳入 Electra 升级的 EIP 的实施情况,包括:1)EIP-6110:将验证者的存款信息添加到执行层的区块结构中以简化共识层的工作; 2)EIP-7002:执行层可触发退出; 3)EIP-7549:将 committee index 移出 attestation; 4)EIP-7251:提高最高有效余额。与此同时,开发人员仍在考虑将 EIP 7547 纳入 Electra 中。

此外,开发人员正在继续开发 peerDAS。peerDas 代表了验证器验证 blob 数据的新设计,从而使验证器可以在每个区块上处理更多的 blob。开发人员建议客户团队将大约 80% 的资源和时间用于实施 Electra EIP,20% 用于 peerDAS 开发。【原文为英文】( 来源 )

2️⃣ Arthur Hayes 播客:加密货币是一艘救生船 带我们逃离动荡周期

导读:Arthur Hayes 最新博客分析了当前的宏观经济形势,并提出了加密救生筏的概念。加密救生筏不仅代表了一种从货币贬值的直接影响中逃脱的手段,也标志着向一个更去中心化、透明和韧性的财务未来的转变。本文由吴说区块链整理。

Arthur Hayes(BitMEX 创始人): 随着我们见证加密市场的持续发展,由投机兴趣和真正的创新驱动,很明显我们是朝着一个更去中心化和民主化的金融系统的更广泛转变的一部分。这种转变不仅关于改变资金的投资地点;它关于改变我们对钱、价值和社区的思考方式。在这一新兴景观中,创造和维持一个引人入胜的叙述或文化的能力,对于项目的成功来说,可能与其技术基础一样关键。总之,加密和文化的交汇,例如模因币和代币化文化运动的兴起,代表了数字资产空间一个迷人且强大的维度。随着传统金融资本流入加密,催化更多的创新和采纳,这一空间的未来看起来既充满希望又不可预测。

本质上,AI 驱动的创新快速节奏挑战了传统的投资模型,推向一个成功不仅需要识别有前景的技术,而且还需要能够快速重新分配资本以响应不断演变的市场动态的情景。在这一背景下投资的未来可能包括一系列策略的混合,包括专注于使能平台和技术,利用代币模型及其流动性和灵活性,以及持续了解并适应技术和市场趋势的最新发展。

至于 Solana,这种在交易吞吐量上的飞跃真的可能使区块链应用主流化。Jump 团队的高频交易背景意味着他们习惯于在毫秒可能意味着数百万美元的环境中运作。将这种思维模式和技术能力应用于区块链,可能会催化新一波的创新和采用。这其中尤其引人注目的是它如何与更广泛的 Solana 生态系统整合。它没有创建新的代币或单独的网络;它在增强现有基础设施,使 Solana 上的一切都可能变得更快、更高效。传统金融专业知识与加密创新之间的这种合作是一种强大的组合。它代表了不同世界的汇聚,共同目标是:使区块链成为新的、更开放金融系统的支柱。( 来源 )

3️⃣ 对话 FLock.io CEO:为什么谷歌不能做真正的联邦学习,而区块链可以?

导读:FLock(基于区块链的联邦学习)通过智能合约和代币经济学引入了真正的联邦学习,确保了更广泛的参与。深潮对话 FLock 首席执行官,讨论民主人工智能的概念,以及其在全球卫生等领域的相关性。

Jiahao Sun: 所谓联邦学习还是一个 Machine Learning 那个框架,只不过把所有的计算分散到每个节点里面去,这样就可以不把数据拿出来,每个人都在每个节点里面做一个 Local Compute,简单来讲就是把结果综合起来,得到一个最后的综合大模型,这个大模型可以体现出所有数据被训练之后的结果,又能够防止需要把数据放到任何第三方的服务器上这件事。所以整个这样一套逻辑就称为联邦学习,最早谷歌他们提出来之后,他们就把这套逻辑用在了输入法预测上。

所以当时很多 Pixel Phone 的用户很早就已经体会到什么是联邦学习了,你用谷歌的手机打字的时候,他会给你预判下一个字。其实这就是联邦学习最早在现实中的应用。但就像我刚刚举的例子一样,同样的,谷歌控制了所有这个 Training 过程,它是可以作恶的,它可以看到所有的源代码,可以看到所有的原数据,没法证伪自己没看到。所以这是为什么我们把区块链智能合约的机制加入到整个传统的联邦学习框架里面,这样就不需要谷歌了,不需要中间有一个人做资源分配,我们每个人都是个独立的个体,我们自己有自己的节点,我只算我的那部分,然后通过智能合约来决定谁上传的 Gradient 是有用的,哪个需要综合起来,全部靠就这一套链上的 Consensus 去解决。这是 FLock 最早作为一个 Research Idea 的一个点。

在这个联邦学习的逻辑里,个人数据从来没有从个体节点出来,出来的东西是你的数据把一个 Local 模型训练完之后这个模型的变化,这个变化值我们称之为梯度(Gradient)。我们只传这个梯度到下一个节点,整个过程中没有任何跟你数据有关的任何东西被传到下一个节点,它是完全保密的。所以理论上不需要做任何的加密,因为这东西本来就不是你的数据。这本质上就不是涉及到区块链或者联邦学习本身这一套机制的问题,而是涉及到节点之间的加密传输,那只要能保证它是安全的就行。我上面说的只是一种解决思路,包括 ZK,包括 FHE,包括 TEE,其实都可以作为解决加密的方案。这里面,FLock 跟所有的这些技术都可以很好的兼容,甚至我们自己还出了一篇 Paper 叫 zkFL。

上下游之间就是互相合作挺好的。因为我们是 Training Layer,只是一层 Layer,在整个构建中的话,我们相当于像 TensorFlow、pyTorch 这样的一个地位,在传统行业里面对标的是训练中层,还是需要 AWS 去放你的模型,你还是需要用 AWS 的 s3 去存你的数据,我们只做串联工作的,算力从哪来? 以及存储方案的解决商也有很多。我觉得数据去中化技术存储可能创新的机会没有那么大,大家都已经很大了。我们第一版的 Test Net 就是在 IPFS 上上下层合作蛮好的,用 Decentralized Compute 能够让普通用户可以无缝的、无难度的体验 FLock 的机制。对我们而言,上下游的合作就是为了让用户体验更好。( 来源 )

4️⃣ 【英文长推】 AC:Ethena 或是下一个 UST?

导读:Andre Cronje 撰文从概述了自己对 Ethena Labs 机制设计的质疑,并称其或是下一个 UST。

Andre Cronje: 永续合约则是一种交易工具,它允许交易者执行类似的操作,但却不用涉及任何现货资产,因此这其实有点像赌博,而不是交易。永续合约的特殊之处在于,做多者和做空者都需要支付「资金费率」。对于交易者而言,要维持自己的交易头寸,你需要做的是提供保证金,保证金本质上是为了「资助」资金费率「债务」的抵押物,如果资金费率转为负数,它将会开始逐步吞噬你的抵押物,直到你的头寸被平仓。

Ethena 的另一项机制在于抵押物的自动生息功能,即只要持有该抵押物,资产便就会持续增值。其实就是 stETH,如果我持有 1 个 stETH,也就是说我正在做多 stETH,那么这时如果我再通过永续合约去开启 1 个 stETH 的做空头寸,理论上我就可以实现「Delta 中性」,因为即使我在 stETH 做空上损失了 100 美元,我也可以 stETH 做多上获得 100 美元。补充两点,一是现在我能找到的可接受 stETH 作为保证金的交易所只有 ByBit,二是此处的「Delta 中性」讨论忽略了资金费率问题。

根据我的经验,任何一笔合约头寸最终都只会迎来两个结局,要么被平仓,要么就得被清算。因此,我目前对于该协议运作机制的理想推断是,当市场转向时,头寸将会被平仓,听起来很明显,实际执行起来却几乎不可能。所以尽管现在看起来一切都很顺利,但这只是因为市场处于看涨情绪下,大家乐意持有多单,做空的资金费率为正,可情况最终一定会发生变化,当做空的资金利率转为负值,抵押物将开始被蚕食甚至被清算,到时候就只会剩下一个没有任何支撑的资产。有些人可能会用「大数定律」来进行反驳,这很像是 UST 当年号称拥有 10 亿美元 BTC 的保障基金 ——「直到它没用的那一天为止,它都挺有用的」。【原文为英文】( 来源 )

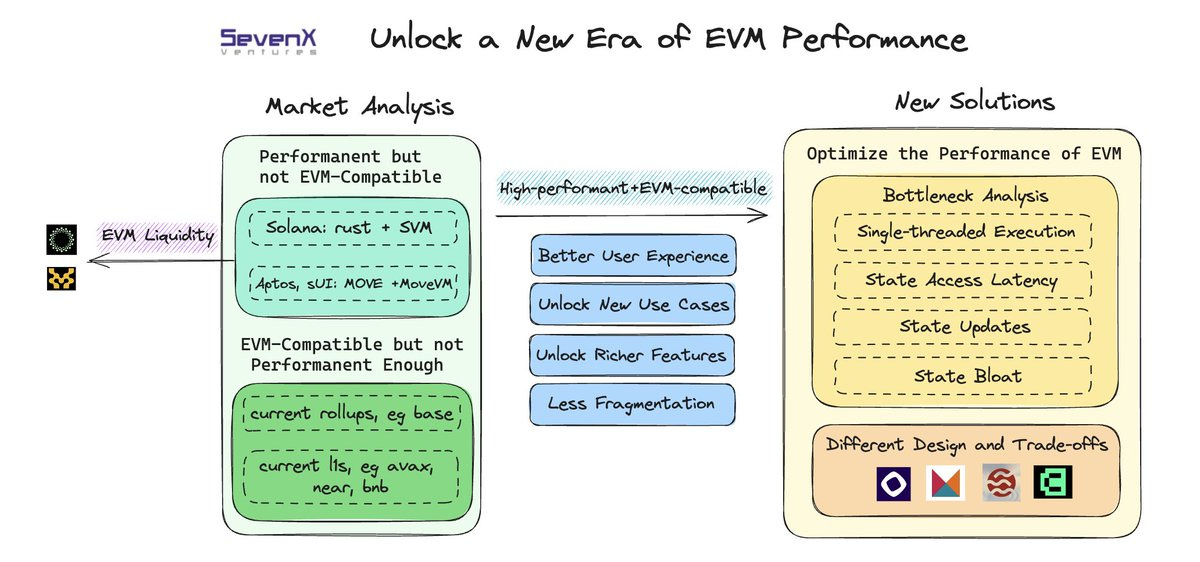

5️⃣ 【英文长推】以 Monad、MegaETH、Sei 和 Canto 为例,探索 EVM 的性能优化设计

导读:SevenX Ventures 研究员 Grace Deng 以 Monad、MegaETH、Sei 和 Canto 为例,综合比较了四个项目在 EVM 优化、性能和去中心化方面的权衡与进展。

Grace Deng: MegaETH 选择了一种异构扩展方法来实现 100-200k TPS:1) 采用 OCC 的强大、优化和中心化排序器(排序和执行);2) 廉价、去中心化的全节点(仅应用压缩状态差异,无需重新执行)。更具体地说,为了解决状态访问问题(减少磁盘 I/O),配备高内存的 MegaETH 排序器将把执行状态保存在内存中。MegaETH 专注于突破 Rollup 的边界,从理论上讲,Rollup 利用了底层的安全性。Rollup 大小将从根本上受到内存大小的限制。硬最终性将受限于证明生成时间(欺诈证明或 zk 证明)。

Sei V2 也采用 OCC 方法进行并行化。为了处理与状态相关的问题,它们采用了名为 IAVL trie 的新状态 trie,以提高读写效率。此外,它们还将活动状态数据存储在 RAM 中,但由于采用了新的 trie,元数据存储量有所减少。

Canto 最近宣布了 Cyclone 升级,其特点是:1)升级到 Cosmos SDK v50 和 ABCI 2.0,实现亚秒级区块时间;2)实现并行执行的 OCC;3)集成内存 IVAL,减少存储访问瓶颈。

Monad 的设计同时推动了去中心化和高性能的界限。在性能方面,Monad 采用了并行化的 OCC、用于快速最终性的 MonadBFT 和新的并行访问 DB。MonadBFT 源自 Hotstuff,它并行化了排序过程和执行过程。Monad 利用新的 DB 解决了状态访问问题,该 DB 利用内核对异步 I/O 的支持,绕过文件系统以避免昂贵的开销,而不是增加内存。Monad 通过一个新的 DB 解决了状态访问问题,该 DB 利用 Kernel 对异步 I/O 的支持并绕过文件系统以避免昂贵的开销,而不是增加 RAM。【原文为英文】( 来源 )

6️⃣ 【英文】EVM 并行化探索:Post-Parallel EVM 时代会如何发展?

导读:鉴于软件系统工程的演进和其他网络可扩展性的成功,EVM 的并行执行是不可避免的。Reforge Research 撰文深入探讨了 EVM 并行执行不可避免的未来及其对行业的深远影响,并表示并行 EVM 将为去中心化应用开启了一个全新的可能性时代。

Reforge: 并行 EVM 项目面临的主要挑战不仅仅是让计算同时运行,而更在于确保在并行化环境中对状态访问和修改的优化。问题的核心集中在两个主要方面: 1)以太坊客户端和以太坊本身使用不同的数据结构进行存储(B-tree/LSM-tree 与 Merkle Patricia Trie),导致在将一个数据结构嵌入到另一个数据结构时性能不佳。 2)在并行执行中,执行异步输入 / 输出(async I/O)以进行交易读取和更新的能力至关重要;进程可能会因等待彼此而陷入停滞,从而浪费任何速度增益。

使用关系模型实现 EVM 状态会增加不必要的复杂性和开销,导致与使用基本键值存储相比, 'sload' 和'sstore' 操作的成本更高。EVM 状态不需要像排序、范围扫描或事务语义这样的特性,因为它只执行点读取和写入操作,而写入操作会在每个区块结束时分开进行。因此,这些改进的需求应集中在解决诸如可扩展性、低延迟读写、高效的并发控制、状态修剪和存档以及与 EVM 的无缝集成等主要考虑因素上。例如,Monad 正在从头开始构建一个定制的状态数据库,名为 MonadDB。它将利用最新的内核支持进行异步操作,同时在磁盘和内存中本地实现 patricia trie 数据结构。

随着并行 EVM 的出现,我们预计 DeFi 活动将大幅增加,主要由可行的链上中心限价订单簿(CLOBs)引领。鉴于 DeFi 天生可组合,可以与无限数量的协议进行交互,以创建大量的交易排列组合。利用这一现象,pCLOB 可以在订单提交过程中嵌入自定义逻辑。此逻辑可以在订单提交之前或之后调用。例如,pCLOB 智能合约可以整合自定义逻辑来:

1)根据预定义规则或市场条件验证订单参数(例如价格和数量)

2)进行实时风险检查(例如,确保杠杆交易的足够保证金或抵押品)

3)根据任何参数(例如,订单类型、交易量、市场波动率等)应用动态费用计算

4)根据指定的触发条件执行条件订单并行 EVM 还改善了 pCLOBs 的撮合引擎。现在,pCLOB 可以实现并行撮合引擎,利用多个 lanes 同时处理订单并执行匹配计算。在与 Monad 联创始 Keone 的一次讨论中,他认为我们可以预期多个 pCLOBs 在不同的高吞吐量生态系统中获得关注。Keone 强调,由于费用更低,这些 pCLOB 将对更广泛的 DeFi 生态系统产生重大影响。

技术角度来看,创建高性能的并行 EVM L2 解决方案比开发 L1 更容易。更具体地说,我们预计,在短期内,基于乐观的并行 EVM L2 将占据主导地位。最终,我们预计将通过像 RISC0 这样的通用 ZK 框架实现从 OP-based Rollups 到 ZK Rollups 的过渡。编程语言选择将在这些系统的演变中起到重要作用。我们更倾向于 Reth,即以太坊的 Rust 实现,而不是其他任何替代品。这种偏好并非随意,因为 Rust 相对于其他语言具有许多优势,包括内存安全而无需垃圾回收、零成本抽象和丰富的类型系统等。【原文为英文】( 来源 )

7️⃣ 【长推】Layer3 概念引激烈讨论,究竟该如何理解其扩展意义?

导读:加密研究员 Haotian 撰文对市场上关于 Layer3 的争论进行了整理,并表示 Layer3 的扩展应该给予应用场景需求做定制开发扩展,类似一键发链的开发范式在 Layer3 应用多链方向走不通。

Haotian: 1)由于 Layer2 和 Layer3 理论上都要依赖主网结算,因此一个常见的假设是,Layer3 先把数据进行压缩,再提交到 Layer2 进行二次压缩。一旦以类似架构去畅想 Layer4、Layer5,这种方式就会被挤进死胡同,毕竟数据不可能一直被压缩。

2)实际上,Layer3 和 Layer2 的交互方式可能并不一定非要压缩再压缩。在 Arbitrum、zkSync 等多家 layer2 Stack 堆栈规划的 Layer3 战略中,Layer3 都被定义为 specific 应用链,会在共识机制、Gas Fee 选择、经济模型等方面高度自治,问题就在这,自治不代表完全独立,其底层架构大概率会被约束应用 Layer2 搭建的基础 infra,比如,和 Layer2 链共享 Sequencer、Prover 等关键组件。这就意味着,Layer3 的交易会被直接经由 Layer2 的 Sequencer 打包提交给主网做最后状态确认。Layer2 更多承接的是 Layer3 多链间的可交互操作性 Function,所谓结算层也只是数据打包的结算,而并非真正意义上的最终确定性结算。Layer3 的交易也需要排队在 Layer2 上进行打包,把 layer3 应用链当成一个特殊的 Sequencer 管道就 Make Sense 了。

3)如果假定 Layer3 都是链间套娃的形式那可扩展性自然有限,但这样的实践方式只是理论假设,若按照 layer2 和 layer3 共享 Sequencer 和 Prover 等关键组件,有很多方法可以让 Layer3 的多链横向扩容,尤其是链间可交互操作性被提升后。

4) Vitalik Buterin 也重申了自己的观点,Layer3 不能被简单是为 Layer2 的堆叠和延伸,这样并不能带来有效扩展性。因为,Layer3 要依赖 Layer2 做基础设施,layer2 都无法做到无止境扩展何况 Layer3。但在一些特定场景下,比如,隐私,Layer3 特定隐私应用链可以解决一部分交易对隐私的偏好。( 来源 )

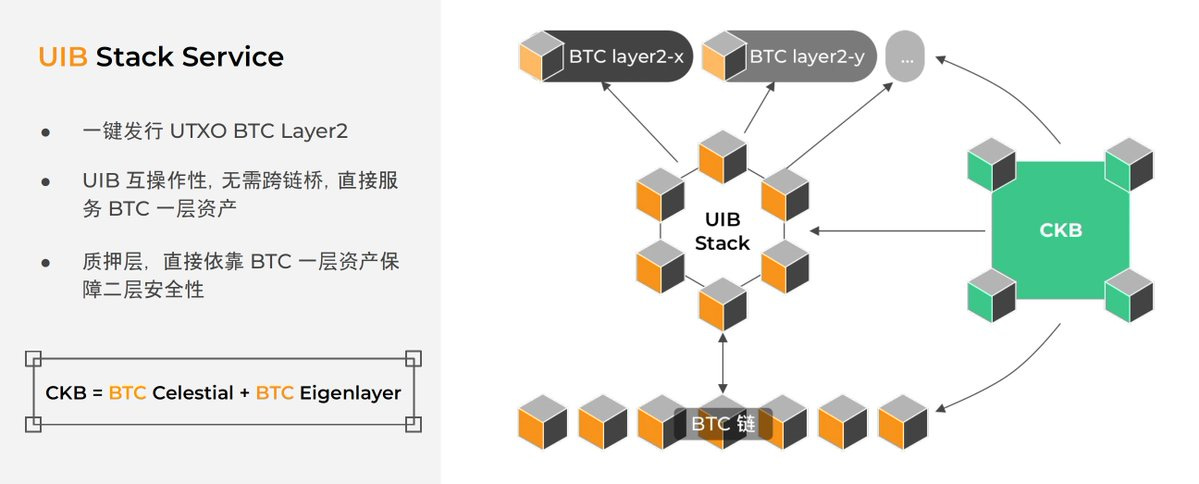

8️⃣ 【长推】ABCDE:我们为什么要投资 UTXO Stack

导读:UTXO Stack 作为比特币生态的「OP Stack + EigenLayer」,可以帮助项目开发者一键发行基于 UTXO 架构的 BTC Layer2,并原生集成 RGB++ 协议能力。在安全性上,通过质押 BTC、CKB 以及 BTC L1 资产以保障 Layer2 安全。

Lao Bai(ABCDE 投研合伙人): Nervos 利用与 BTC 同是 POW+UTXO 的天然结构性优势 + 创新型的「同构映射」技术把 RGB 的客户端验证范式「无缝搬迁」到 CKB 上,命名为 RGB++。牺牲少许隐私的前提下换来了极大的功能与灵活性拓展,且安全性与 BTC L1 形成了强绑定。更重要的是,RGB++ 在几天前真正落地了,意味着这不再是一个停留在概念或开发层面的扩容叙事,而是实实在在可以开始构建生态和解决方案的产品。

有了 UTXO Stack,你可以一键发行 BTC 的同构 UTXO Appchain,这些 Appchain 有如下特性:

UTXO 模型,超高 TPS (UTXO 天生自带并行处理),超低 Gas 费用;

POS 机制,安全性由 BTC 上质押的 BTC/CKB 来提供(类似 EigenLayer);

资产协议采用 RGB++,因为同构映射技术的存在,资产可以在 Appchain/CKB/BTC 之间任意跳转,无需跨链桥;

可以复用 CKB 智能合约栈;

可以复用 BTC 钱包(用户对于 CKB 链无感知)。

可以预见的是,在不久的未来,BTC EVM layer2 与 BTC UTXO layer2 会在技术,生态,乃至意识形态多个层面展开一轮正面对抗。RGB++ 从 2 月正式提出到 4 月落地,只用了不到两个月时间,展现出团队极其强大的工程能力。UTXO Stack 在 RGB++ 落地的同时推出,更给予了 BTC 生态资产发行与玩法上更加多样 + Bitcoin Native 的可能性。( 来源 )

9️⃣ 以太坊验证者数量超 100 万,「彩虹质押」如何缓解质押中心化问题?

导读:2024 年的 Eth 台北会议上,Vitalik Buterin 还对「Rainbow staking」的想法进行了分析,这种方法鼓励服务提供商多样性,可以作为解决以太坊所面临的中心化问题的手段。

Ebunker: 根据 Dune 数据,3 月 28 日,以太坊的验证者数量中达到 100 万的重要里程碑。社区的讨论点围绕着验证者集的增长,尤其在 Shapella 升级使以太坊质押可以灵活撤出之后,这是以太坊向更可扩展和节能网络发展的关键。但是,随着验证者数量的增加,每个验证者都必须独立下载最新数据并在受约束的时间范围内验证状态变化。这意味着它们需要更多的计算能力,以实现较大的数据区块。据统计,目前至少有 85 万个验证者属于用户将 ETH 托管给中心化平台进行质押的情况,因为大部分 ETH 持有者不具备 32 枚以上的 ETH,或者无法自行应付复杂的质押操作。这就引发了另一个关注点 — — 加剧中心化的潜在风险。

3 月 27 日,Vitalik Buterin 提出了「反相关激励」的创新计划,旨在应对在验证者中心化的问题,加大对大型验证者出现故障的惩罚,增强以太坊质押机制的去中心化和公平性。Vitalik Buterin 认为,如果由同一实体控制的多个验证者一起出故障,他们将受到比单独验证者故障更高的罚款,因为大型验证者犯的任何错误都将在其控制的所有身份中复制。例如,同一集群中的验证器(如 Staking Pool)更有可能经历相关的故障,可能是由于共享基础架构所致。该提案建议对偏离平均故障率的验证者进行惩罚相应的惩罚。 如果许多验证者在给定的插槽中出故障,则每个故障的罚款将更高。除此之外,Vitalik Buterin 还提出了其他选择,例如不同的惩罚方案,以最大程度地降低大型验证者的优势,并检查对地理和客户去中心化的影响。

Rainbow staking 可以分为重型质押和轻型质押,在这种特殊情况下,重型质押是可罚没的,并且在每个插槽中都有签名。 相反,轻型质押不可罚没,它通过彩票系统签名。现在试图明确地将这二者分开,并有可能要求二者在一个区块上签名,以使区块最终确定,即尝试将这两种方法的安全性添加在一起。以太坊非托管质押服务商 Ebunker 合伙人 Todd 表示,过去,小额质押者在 ETH 网络的验证工作中,基本属于角色缺失。彩虹质押的核心目的,是让小额的 ETH 质押者,通过很轻量级的方式参与到网络验证。然后,凭借参与人数的增加,来部分抵消掉头部机构和协议持有大量 Staking ETH 的中心化影响。( 来源 )

1️⃣0️⃣ 【英文】从存储过去到计算未来: AO 超并行计算机

导读:AO 究竟是什么?支持其性能的逻辑又从何而来?YBB Capital 研究员 Zeke 撰文进行了分析解读。

YBB Capital: AO 与常见网络的区别:与以太坊等网络不同,AO 的基础层和每个 Rollup 实际上都作为单一进程运行,AO 支持任意数量的进程并行运行,同时确保计算的可验证性保持完整。此外,这些网络在全球同步状态下运行,而 AO 进程保持自己的独立状态。这种独立性使得 AO 进程能够处理更高数量的交互和计算的可扩展性,使其特别适合对高性能和可靠性有需求的应用程序、此外, AO 可以提供交互的可验证复现性,或者依赖于非永久性存储解决方案来保存它们的交互日志。

AO 的节点网络与传统计算环境的不同之处:AO 支持各种形式的线程,无论是基于 WASM 还是 EVM 的,都可以通过一定的技术手段架接到 AO 上;AO 支持内容共创类的项目,可以在 AO 上发布 atomic NFT,上传数据结合 UDL 在 AO 上构建 NFT;AR 和 AO 上的 NFT 可以实现数据组合性,允许一篇文章或内容在多个平台上共享和显示,同时保持数据源的一致性和原始属性。当内容发生更新时,AO 网络能够将这些更新状态广播给所有相关平台,确保内容的同步和最新状态的传播;内容创作者可以将他们的作品作为 NFT 出售,并通过 AO 网络传递所有权信息,实现内容的价值回馈。

AO 是链下实现,也不解决可验证性问题,也不更改共识。AR 团队的思路是将 AO 与 Arweave 的职能剥离,再模块化衔接,AO 只进行通信与计算,Arweave 只提供存储与验证。两者的关系更像是映射,AO 只需确保交互日志存储在 Arweave 上,其状态就可以投影到 Arweave,从而创建全息图,这种全息状态投影保证了在计算状态时输出的一致性、可靠性、确定性。此外通过 Arweave 上的消息日志也可反向触发 AO 进程执行特定的操作。如果把验证逻辑说的再简单一点,那么可以将 AO 想象为一个基于超并行索引器的铭文计算框架,任何人都可以通过 Arweave 上的全息数据恢复 AO 或者 AO 上的任何一个线程。用户也不需要跑全节点去验证可信状态,同更换索引一样,用户只需通过 SU 向单个或多个 CU 节点提出查询请求即可。而 Arweave 的存储能力高且费用低廉,所以在这套逻辑下,AO 开发者可以实现远超比特币铭文功能的超级计算层。( 来源 )